Blog

Fake News war gestern. Jetzt kommt Deep Fake!

Die Gefahr, die von Deep Fake Videos ausgeht, wird massiv unterschätzt

Vor einigen Tagen war der Schauspieler Bill Hader beim Interview mit Conan O’Brien dabei zu sehen, wie er Arnold Schwarzenegger imitiert. Spannend waren dabei weniger die Schauspielkünste des US Schauspielers als vielmehr das Video, dass der slowakische Youtuber „Ctrl Shift Face“ daraus machte. Im Gesprächsverlauf verwandelte sich das Gesicht von Bill Harder in das von Arnold Schwarzenegger – ein Deep Fake. Eine nette technische Spielerei könnte man meinen, aber das Thema hat einen ernsten Hintergrund.

Vielleicht hat alles 2004 mit „The Yes Men“ angefangen. Die politische Künstlergruppe aus den USA hatte gefakte Webseiten ins Netz gestellt und wurden daraufhin zu Konferenzen eingeladen. Dort agierten sie dann im Namen fremder Organisationen, wie der Welthandelsorganisation WTO. Legendär war ihr „Dow Chemical Hack“ bei dem sie live im BBC Fernsehen vor Millionen von Zuschauern den Opfern eines Chemie Unfalls 12 Milliarden Dollar Entschädigung versprachen. Nun hatte Dow Chemical das Problem, der Welt zu erklären, dass man weder rechtlich verantwortbar, noch irgendwas zu zahlen bereit sei.

Der Begriff „Fake News“ vollzieht seitdem eine steile Karriere von der unterhaltsamen Satire zum politischen Kampfbegriff. Zu „Fake News“ als Ausdruck für bewusste Falschmeldungen wurde der Begriff aber vor allem zur Benennung satirischer Beiträge von „The Daily Show“ oder „The Onion“. Der Durchbruch in den allgemeinen Sprachgebrauch erfolgte im Zusammenhang mit dem Aufkommen einer großen Anzahl politisch motivierter Falschmeldungen, die Einfluss auf den Präsidentschaftswahlkampf von Donald Trump in den USA genommen haben soll. Seither wird über Fake News viel gestritten und geforscht. Was passiert mit einer Gesellschaft, die Fakten nicht mehr akzeptiert? Was, wenn die Wahrheit zwischen „alternativen” und echten Tatsachen verloren geht?

Der Mensch glaubt felsenfest, was er sieht. Das wird mit Deep Fake zum Problem

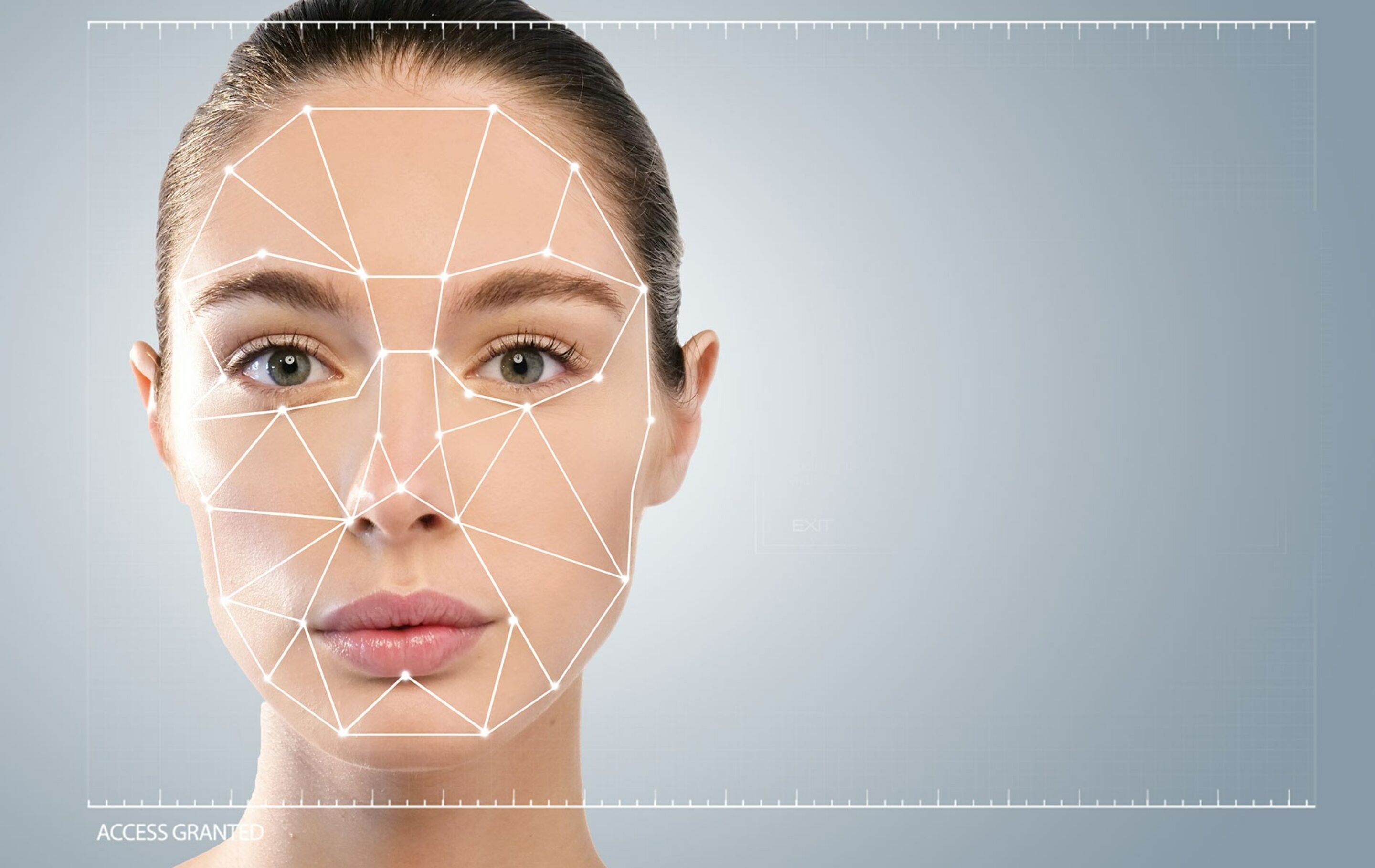

Viele Experten behaupten, dass Phänomen „Fake News“ sei grundsätzlich beherrschbar, weil sie sich alle Informationen in letzter Konsequenz verifizieren und mit anderen Quellen abgleichen lassen. Das ist mühsam, macht aber die dauerhafte Existenz großer Lügen zumindest unwahrscheinlich. Dramatischer wird es, wenn sich Kampagnen auf ein Quelle berufen, die das buchstäblich Offensichtliche zeigt. Der Mensch glaubt, was er sieht. Jemanden zu überzeugen, der glaubt, alternative Fakten mit eigenen Augen gesehen zu haben, ist nahezu unmöglich. Und genau darum geht es bei Deep Fake. Es ist der Ausdruck für die Technik, mit Hilfe von künstlicher Intelligenz täuschend echt wirkende Bilder oder Videos herzustellen, die nicht echt sind. Die Technik basiert auf künstlichen neuronalen Netzwerken, die die gefälschten Medien weitgehend autonom erzeugen. Durch die Fortschritte der AI wird es bald nahezu unmöglich sein, mit bloßem Auge zwischen Wahrheit und Lüge zu unterscheiden.

Im Herbst 2017 stellte ein anonymer Reddit Nutzer mehrere Pornovideos ins Internet. Schauspielerinnen wie Gal Gadot und Emma Watson sowie die Sängerinnen Katy Perry oder Taylor Swift waren bei vermeintlichen Sexszenen zu sehen. Diese Szenen waren nicht echt, sondern unter Verwendung künstlicher Intelligenz erstellt worden. Als Trainingsdaten für sein Neuronales Netz hatte der Reddit-Nutzer Szenen aus Spielfilmen mit den Prominenten verwendet und mit pornographischen Videos kombiniert. Im April 2018 veröffentlichte der US-amerikanische Kabarettist Jordan Peele ein Deep-Fake-Video, in dem er Barack Obama vor den Gefahren manipulierter Videos warnen lässt. In diesem Video bezeichnet der virtuell inszenierte Ex-Präsident seinen Nachfolger Donald Trump als „kompletten Volltrottel“.

Ende Januar 2018 startete die sogenannte FakeApp, mit der auch Amateurnutzer in Videos sehr einfach Gesichter austauschen können. Ein Algorithmus berechnet mithilfe eines künstlichen neuronalen Netzes und der Leistung des Grafikprozessors sowie ein paar Gigabyte Festplattenspeicher das zu erzeugende Fake-Video. Für genaue Angaben braucht das Programm allerdings viel Bildmaterial von der einzufügenden Person, um mithilfe des erwähnten Deep-Learning-Algorithmus auf Basis der Videosequenzen und Bilder zu lernen, welche Bildelemente ausgetauscht werden müssen. Die Software nutzt dabei das KI Framework TensorFlow von Google welches unter anderem bereits für das Programm DeepDream verwendet wurde. Aber die nächste Generation steht schon in den Startlöchern. Samsung hat nun gerade eine Deep Fake KI vorgestellt mit der ein Video von einer Person schon aus einem einzigen Profilbild erstellt werden kann!

Mehr oder weniger alle großen Technologiefirmen experimentieren also mit Technologie, die mit bösartiger Absicht für hochwertige Deep Fake Videos genutzt werden kann. Wenn sogar ein grob manipuliertes Video von US-Sprecherin des US-Repräsentantenhauses Nancy Pelosi in Social Media viral werden kann, wecken Deep Fakes die Befürchtung, dass ihre Raffinesse die Massentäuschung erleichtern kann, da sie viel schwerer zu entlarven sind. Forscherin Hany Farid, die sich auf Medienforensik spezialisiert hat, meint dazu: „Diese Art von Techniken und ihre rasante Entwicklung bergen das hohe Risiko von Fehlinformationen, Wahlmanipulationen und Betrug.“

„Ich glaube nur das, was ich sehe“ wird im Zeitalter des einseitigen Medienkonsums in der Bubble zur Falle

Es ist schon erstaunlich, wie wenig derzeit über die Gefahr von Deep Fake Videos gesprochen wird. Man muss nicht über viel Fantasie verfügen, um sich auszumalen, welchen Schaden für einzelne Personen des öffentlichen Lebens oder auf gesellschaftlicher Ebene durch die Manipulation von Fotos und Videos entstehen kann. Der Google-Ingenieur Ian Goodfellow bezeichnet es als einen„historischen Glücksfall“, dass wir uns „bisher auf Videos als Beweis für Tatsachen verlassen konnten“. Digital Natives sind weniger bereit lange Text-Passagen zu lesen und bedienen sich nicht unbedingt vielfältiger Quellen um den Informationsgehalt gelesener Artikel abzusichern. Es wird zu einem hohen Prozentsatz Bewegt-Bild-Content konsumiert. Das ohnehin schon angeschlagene Vertrauen in Medien kann jederzeit massiv erschüttert werden, wenn diese auf ein Deep Fake Video hereinfallen. Wer aus niederen Beweggründen die Deep Fake Technologie für sich nutzen möchte, wird sich problemlos in die Anonymität flüchten können. Rechtlich bekommen wir das Problem daher kaum in den Griff.

Die großen IT Konzerne stehen als AI-Experten in der Verantwortung

Es bleibt uns also nichts anderes übrig, als konsequent zu sensibilisieren auf die Gefahren durch Deep Fake hinzuweisen. Zumindest die großen Leitmedien sollten Experten beschäftigen und technisch aufrüsten, um echte von gefälschten Videos unterscheiden zu können. Aber in Verantwortung stehen zuallererst die großen Internetkonzerne. Sie müssen Mittel und Wege finden, um Videos, die mit ihrer AI bearbeitet wurden nachhaltig zu kennzeichnen. Sonst wird aus der Technologie eine Waffe. Und es wird Menschen geben die sie für ihre Zwecke einsetzen werden. Wir können davon ausgehen: Die Lawine rollt bereits!